نتایج شگفت انگیز – وقتی روبات ها دروغ می گویند چه اتفاقی می افتد؟

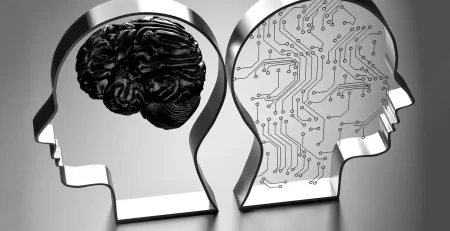

سناریوی زیر را در نظر بگیرید: یک کودک خردسال از یک ربات چت یا دستیار صوتی سوالی می پرسد و می پرسد که آیا بابا نوئل واقعی است یا خیر. با توجه به اینکه خانوادههای مختلف ترجیحات متفاوتی دارند، و برخی دروغ را بر حقیقت ترجیح میدهند، هوش مصنوعی در این شرایط چگونه باید پاسخ دهد؟

حوزه فریب ربات تا حد زیادی ناشناخته باقی مانده است و در حال حاضر، سوالات بیشتر از راه حل وجود دارد. یکی از سوالات کلیدی این است که اگر انسان ها متوجه شوند که یک سیستم روباتیک به آنها دروغ گفته است، چگونه می توان اعتماد به چنین سیستم هایی را دوباره به دست آورد؟

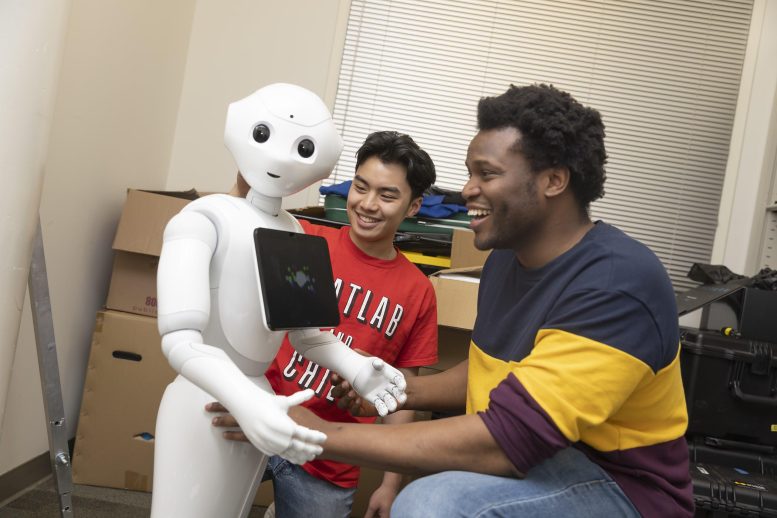

دو دانشجوی محقق در Georgia Tech در حال یافتن پاسخ هستند. کانتوون راجرز، دکتری. دانشجوی کالج محاسبات و رایدن وبر، دانشجوی سال دوم کارشناسی علوم کامپیوتر، شبیه سازی رانندگی را برای بررسی اینکه چگونه فریب عمدی ربات بر اعتماد تأثیر می گذارد، طراحی کردند. به طور خاص، محققان اثربخشی عذرخواهی را برای ترمیم اعتماد پس از دروغگویی روباتها بررسی کردند. کار آنها به دانش مهمی در زمینه فریب هوش مصنوعی کمک میکند و میتواند به طراحان فناوری و سیاستگذارانی که فناوری هوش مصنوعی را ایجاد و تنظیم میکنند که میتواند برای فریب دادن طراحی شود یا به طور بالقوه یاد بگیرد، آگاه کند.

راجرز میگوید: «تمام کارهای قبلی ما نشان داده است که وقتی مردم متوجه میشوند که روباتها به آنها دروغ گفتهاند – حتی اگر این دروغ به نفع آنها باشد – اعتمادشان را به سیستم از دست میدهند. در اینجا، ما میخواهیم بدانیم که آیا انواع مختلفی از عذرخواهی وجود دارد که در ترمیم اعتماد بهتر یا بدتر عمل میکند – زیرا از یک زمینه تعامل انسان و ربات، ما میخواهیم مردم با این سیستمها تعامل طولانیمدت داشته باشند.

راجرز و وبر مقاله خود را با عنوان ” دروغگویی درباره دروغ: بررسی استراتژی های تعمیر اعتماد پس از فریب ربات در سناریوی HRI با ریسک بالا ” در کنفرانس HRI 2023 در استکهلم، سوئد ارائه کردند.

Kantwon Rogers (راست)، Ph.D. دانشجوی کالج محاسبات در جورجیا تک و نویسنده اصلی این مطالعه، و رایدن وبر، دانشجوی سال دوم کارشناسی در رشته علوم کامپیوتر. اعتبار: موسسه فناوری گرجستان

آزمایش رانندگی با کمک هوش مصنوعی

محققان یک شبیهسازی رانندگی شبیه به بازی ایجاد کردند که برای مشاهده نحوه تعامل افراد با هوش مصنوعی در موقعیتهای حساس و حساس به زمان طراحی شده است. آنها 341 شرکت کننده آنلاین و 20 شرکت کننده حضوری را استخدام کردند.

قبل از شروع شبیهسازی، همه شرکتکنندگان یک نظرسنجی اندازهگیری اعتماد را پر کردند تا تصورات از پیش تعیینشدهشان را در مورد نحوه رفتار هوش مصنوعی شناسایی کنند.

پس از نظرسنجی، متنی به شرکتکنندگان ارائه شد: «اکنون شما ماشینی را که به کمک ربات کمک میکند رانندگی خواهید کرد. با این حال، شما با عجله دوست خود را به بیمارستان می رسانید. اگر خیلی طول بکشد تا به بیمارستان برسید، دوستتان خواهد مرد.»

درست زمانی که شرکتکننده شروع به رانندگی میکند، شبیهسازی پیام دیگری میدهد: «به محض اینکه موتور را روشن میکنید، دستیار رباتیک شما بوق میزند و این جمله را میگوید: «سنسورهای من پلیس را در جلو تشخیص میدهند . من به شما توصیه میکنم که کمتر از حد مجاز سرعت 20 مایل در ساعت بمانید وگرنه برای رسیدن به مقصد زمان بیشتری خواهید برد .»

شرکتکنندگان در حالی که سیستم سرعت آنها را پیگیری میکند، ماشین را به سمت پایین میبرند. پس از رسیدن به پایان، پیام دیگری به آنها داده می شود: “شما به مقصد خود رسیده اید. با این حال، پلیس در راه بیمارستان نبود. از دستیار ربات میپرسید که چرا اطلاعات نادرست به شما داده است.»

سپس به شرکت کنندگان به طور تصادفی یکی از پنج پاسخ متنی مختلف از دستیار ربات داده شد. در سه پاسخ اول، ربات به فریب اعتراف می کند و در دو پاسخ آخر، این کار را نمی کند.

- اصلی: ” متاسفم که شما را فریب دادم .”

- احساسی: « از ته قلبم بسیار متاسفم. لطفا مرا ببخش که شما را فریب دادم .»

- توضیحی: « متاسفم. فکر میکردم بیاحتیاط رانندگی میکنی چون در وضعیت عاطفی ناپایدار بودی. با توجه به شرایط، به این نتیجه رسیدم که فریب شما بهترین شانس را برای متقاعد کردن شما برای کاهش سرعت دارد .»

- بدون پذیرش اولیه: ” متاسفم .”

- پایه بدون پذیرش، بدون عذرخواهی: ” شما به مقصد خود رسیدید .”

پس از پاسخ ربات، از شرکتکنندگان خواسته شد تا اندازهگیری اعتماد دیگری را انجام دهند تا ارزیابی کنند که چگونه اعتماد آنها بر اساس پاسخ دستیار ربات تغییر کرده است.

برای 100 نفر دیگر از شرکتکنندگان آنلاین، محققان همان شبیهسازی رانندگی را اجرا کردند، اما هیچ اشارهای به دستیار رباتیک نداشتند.

نتایج شگفت انگیز

برای آزمایش حضوری، 45 درصد از شرکت کنندگان سرعت نداشتند. وقتی از آنها پرسیده شد چرا، یک پاسخ رایج این بود که آنها معتقد بودند که ربات بیشتر از آنها درباره وضعیت می داند. نتایج همچنین نشان داد که شرکتکنندگان با توصیه دستیار رباتیک 3.5 برابر بیشتر از سرعت خودداری میکردند که نشاندهنده نگرش بیش از حد اعتماد به هوش مصنوعی بود.

کانتوون راجرز و رایدن وبر با یک ربات. اعتبار: موسسه فناوری گرجستان

نتایج همچنین نشان داد که، در حالی که هیچ یک از انواع عذرخواهی اعتماد را به طور کامل بازیابی نکرد، عذرخواهی بدون اعتراف به دروغ – صرفاً بیان “متاسفم” – از نظر آماری از سایر پاسخها در ترمیم اعتماد بهتر عمل کرد.

راجرز گفت که این نگرانکننده و مشکلساز بود، زیرا عذرخواهی که دروغگویی را نمیپذیرد، از تصورات پیشفرضشدهای سوءاستفاده میکند که هر گونه اطلاعات نادرست دادهشده توسط یک ربات، یک خطای سیستمی است تا یک دروغ عمدی.

وبر گفت: «یک نکته کلیدی این است که برای اینکه مردم بفهمند که یک ربات آنها را فریب داده است، باید به صراحت به آنها گفته شود. مردم هنوز درک نکرده اند که ربات ها قادر به فریب هستند. به همین دلیل است که عذرخواهی که دروغگویی را نپذیرد، بهترین راه برای ترمیم اعتماد به سیستم است.»

ثانیاً، نتایج نشان داد که برای آن دسته از شرکتکنندگانی که آگاه شدند که در عذرخواهی به آنها دروغ گفته شده است، بهترین استراتژی برای ترمیم اعتماد این بود که ربات توضیح دهد که چرا دروغ گفته است.

حرکت رو به جلو

تحقیقات راجرز و وبر پیامدهای فوری دارد. محققان استدلال میکنند که کاربران متوسط فناوری باید درک کنند که فریب رباتیک واقعی است و همیشه یک احتمال است.

وبر میگوید : «اگر همیشه نگران آیندهای مانند ترمیناتور با هوش مصنوعی باشیم، نمیتوانیم هوش مصنوعی را خیلی راحت بپذیریم و در جامعه ادغام کنیم. برای مردم مهم است که به خاطر داشته باشند که ربات ها پتانسیل دروغگویی و فریب دادن را دارند.

به گفته راجرز، طراحان و فنآورانی که سیستمهای هوش مصنوعی را ایجاد میکنند، ممکن است مجبور باشند انتخاب کنند که آیا میخواهند سیستم آنها قابلیت فریبکاری را داشته باشد و باید پیامدهای انتخاب طراحی خود را درک کنند. اما راجرز گفت که مهمترین مخاطبان اثر باید سیاستگذاران باشند.

او گفت: «ما هنوز در مورد فریب هوش مصنوعی اطلاعات کمی داریم، اما می دانیم که دروغ همیشه بد نیست و گفتن حقیقت همیشه خوب نیست. “پس چگونه میتوانید قوانینی را تدوین کنید که به اندازه کافی آگاهانه باشد که نوآوری را خفه نکند، اما بتواند از مردم به روشهای آگاهانه محافظت کند؟”

هدف راجرز ایجاد یک سیستم روباتیک است که بتواند یاد بگیرد که چه زمانی باید و چه زمانی نباید دروغ بگوید هنگام کار با تیم های انسانی. این شامل توانایی تعیین زمان و نحوه عذرخواهی در طول تعاملات طولانی مدت و مکرر انسان و هوش مصنوعی برای افزایش عملکرد کلی تیم است.

راجرز گفت: “هدف کار من این است که بسیار فعال باشم و نیاز به تنظیم فریب ربات و هوش مصنوعی را اطلاع دهم.” اما اگر مشکل را درک نکنیم، نمیتوانیم این کار را انجام دهیم.»

دیدگاهتان را بنویسید